標簽:控制 www ret 依賴 com 誤差 net 應用 over

1、GRU概述

GRU是LSTM网络的一种效果很好的变体,它较LSTM网络的结构更加简单,而且效果也很好,因此也是当前非常流形的一种网络。GRU既然是LSTM的变体,因此也是可以解决RNN网络中的长依賴问题。

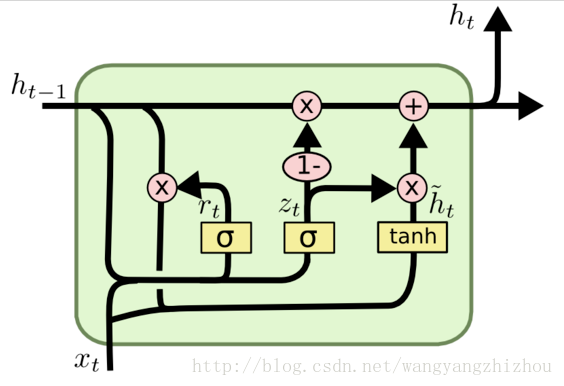

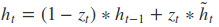

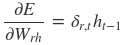

在LSTM中引入了三個門函數:輸入門、遺忘門和輸出門來控制輸入值、記憶值和輸出值。而在GRU模型中只有兩個門:分別是更新門和重置門。具體結構如下圖所示:

圖中的zt和rt分別表示更新門和重置門。更新門用于控制前一時刻的狀態信息被帶入到當前狀態中的程度,更新門的值越大說明前一時刻的狀態信息帶入越多。重置門控制前一狀態有多少信息被寫入到當前的候選集 ?? ??h~t 上,重置門越小,前一狀態的信息被寫入的越少。

2、GRU前向傳播

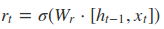

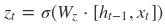

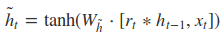

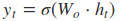

根據上面的GRU的模型圖,我們來看看網絡的前向傳播公式:

其中[]表示兩個向量相連,*表示矩陣的乘積。

3、GRU的訓練過程

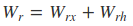

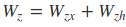

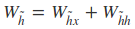

從前向傳播過程中的公式可以看出要學習的參數有Wr、Wz、Wh、Wo。其中前三個參數都是拼接的(因爲後先的向量也是拼接的),所以在訓練的過程中需要將他們分割出來:

輸出層的輸入:

輸出層的輸出:

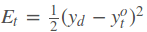

在得到最終的輸出後,就可以寫出網絡傳遞的損失,單個樣本某時刻的損失爲:

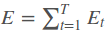

則單個樣本的在所有時刻的損失爲:

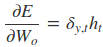

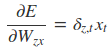

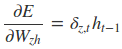

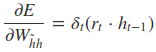

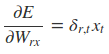

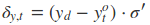

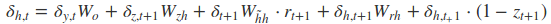

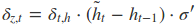

采用后向誤差传播算法来学习网络,所以先得求损失函数对各参数的偏导(总共有7个):

其中各中間參數爲:

在算出了對各參數的偏導之後,就可以更新參數,依次叠代知道損失收斂。

概括来说,LSTM和CRU都是通过各种门函数来将重要特征保留下来,这样就保证了在long-term传播的时候也不会丢失。此外GRU相对于LSTM少了一个门函数,因此在参数的数量上也是要少于LSTM的,所以整体上GRU的训练速度要快于LSTM的。不过对于两个网络的好坏还是得看具体的應用场景。

參考文獻:

抄襲:

GRU神經網絡

GRU與LSTM總結

標簽:控制 www ret 依賴 com 誤差 net 應用 over

原文地址:https://www.cnblogs.com/ccfco/p/15065915.html